Τα τελευταία χρόνια, η Apple έχει εδραιώσει τη φήμη της ως εταιρείας που εστιάζει στην προστασία της ιδιωτικής ζωής. Αναφέρει συχνά την προσέγγιση του «περιτειχισμένου κήπου» ως όφελος για την προστασία της ιδιωτικής ζωής και της ασφάλειας. Ωστόσο, ένα νέο δημοσίευμα από τους Financial Times θέτει αυτή τη φήμη υπό αμφισβήτηση. Ο λόγος που η Apple θα «θυσιάσει την ιδιωτικότητα του iPhone» με αυτόν τον τρόπο είναι για να να σταματήσει την κακοποίηση παιδιών. Το σύστημα φέρεται να είναι γνωστό ως «neuralMatch». Ουσιαστικά, το σύστημα θα χρησιμοποιήσει λογισμικό για τη σάρωση εικόνων που δημιουργούσαν οι χρήστες στα προϊόντα της Apple. Εάν το λογισμικό εντοπίσει οποιοδήποτε μέσο που θα μπορούσε να περιλαμβάνει κακοποίηση παιδιών – συμπεριλαμβανομένης της παιδικής πορνογραφίας – θα ειδοποιηθεί ένας υπάλληλος. Στη συνέχεια, ο άνθρωπος θα αξιολογήσει τη φωτογραφία για να αποφασίσει ποια ενέργεια πρέπει να γίνει.

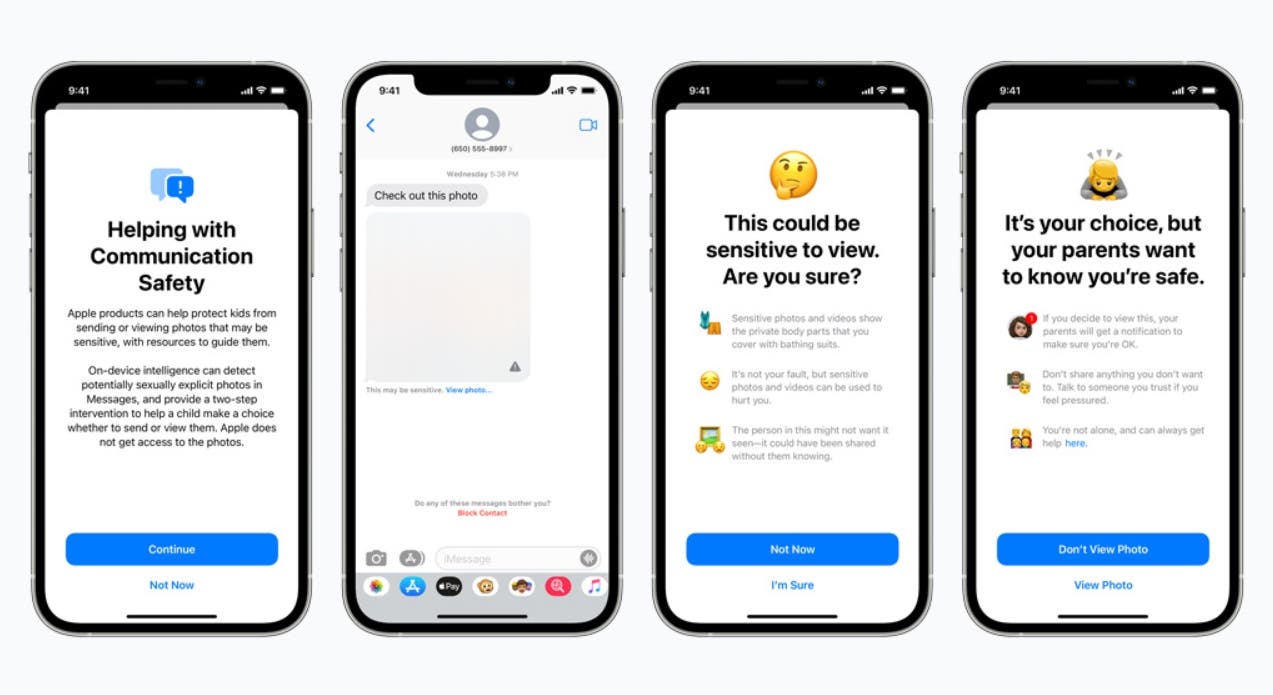

Η Apple δεν άργησε να επιβεβαιώσει την ύπαρξη του λογισμικού της. Σε μια ανάρτηση ιστολογίου με τίτλο «Διευρυμένη προστασία για τα παιδιά», η εταιρεία παρουσίασε σχέδια για να βοηθήσει στον περιορισμό του υλικού σεξουαλικής κακοποίησης παιδιών (CSAM). Στο πλαίσιο αυτών των σχεδίων, η Apple θα παρουσιάσει νέα τεχνολογία σε iOS και iPadOS που «θα επιτρέψει στην Apple να εντοπίσει γνωστές εικόνες CSAM που είναι αποθηκευμένες στις Φωτογραφίες iCloud». Ουσιαστικά, θα πραγματοποιηθεί σάρωση στη συσκευή για όλα τα μέσα που είναι αποθηκευμένα στις Φωτογραφίες iCloud. Εάν το λογισμικό διαπιστώσει ότι μια εικόνα είναι ύποπτη, θα την στείλει σε υπάλληλο της Apple ο οποίος θα αποκρυπτογραφήσει την εικόνα και θα την δει. Εάν διαπιστώσει ότι το περιεχόμενο είναι, στην πραγματικότητα, παράνομο, θα ειδοποιήσει τις αρχές. Η Apple ισχυρίζεται ότι υπάρχει «ένα στο ένα τρισεκατομμύριο πιθανότητες ετησίως να επισημάνει εσφαλμένα έναν δεδομένο λογαριασμό».

Προφανώς, η εκμετάλλευση και κακοποίηση παιδιών είναι ένα τεράστιο πρόβλημα και ένα πρόβλημα που κάθε άνθρωπος γνωρίζει πως πρέπει να αντιμετωπιστεί γρήγορα και σθεναρά. Ωστόσο, η ιδέα κάποιου στην Apple να βλέπουν τις φωτογραφίες των παιδιών σας που το neuralMatch μπορεί να επισημάνει κατά λάθος ως παράνομη είναι ένα σοβαρό θέμα για όλους τους πελάτες της εταιρείας. Υπάρχει επίσης η ιδέα ότι το λογισμικό που έχει σχεδιαστεί για να εντοπίζει την κακοποίηση παιδιών τώρα θα μπορούσε να εκπαιδευτεί για να εντοπίσει κάτι άλλο αργότερα. Είναι πιθανό η Apple να δημοσιοποιήσει αυτό το σύστημα σε λίγες μέρες. Θα πρέπει να περιμένουμε και να δούμε πώς θα αντιδράσει ο κόσμος, αν προχωρήσει η Αμερικανική εταιρεία στα σχέδια της.

Ακολουθήστε το Gizchina Greece στο Google News για να μαθαίνετε πρώτοι και άμεσα, όλα τα τεχνολογικά νέα! Αν ψάχνετε HOT προσφορές, κάντε εγγραφή στο κανάλι μας στο Telegram!